Как оптимизировать robots.txt в SEO

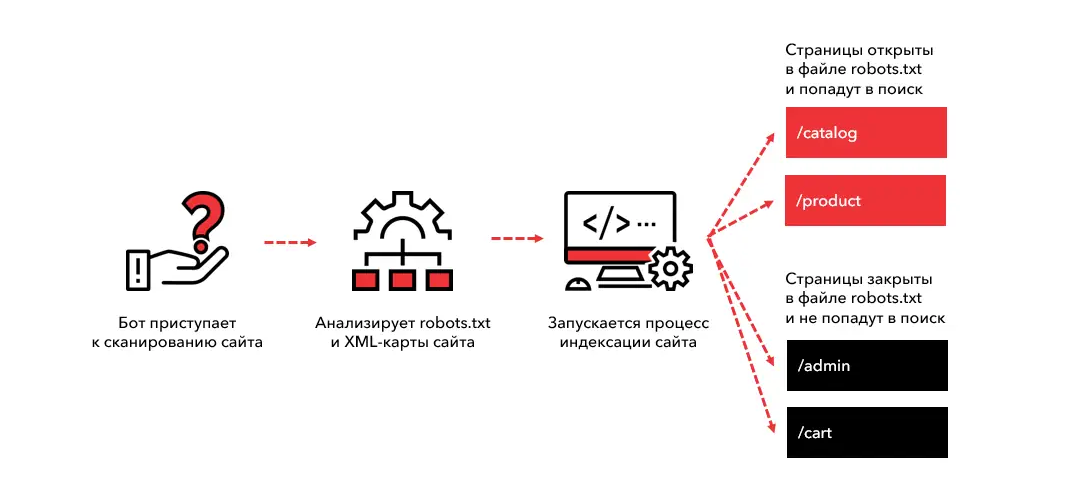

Если бы поисковые системы были гостями, посещающими ваш сайт, файл robots.txt можно было бы назвать хозяином, который определяет, куда этим гостям можно зайти, а куда нет.

Этот простой текстовый файл играет ключевую роль в управлении тем, как поисковые роботы сканируют и индексируют страницы вашего сайта. Но его значение выходит далеко за рамки технических нюансов. Правильная настройка robots.txt — это стратегический инструмент, позволяющий улучшить SEO вашего сайта.

Что такое файл robots.txt?

Файл robots.txt — это текстовый документ, который находится в корневом каталоге вашего сайта. Его цель — указать поисковым роботам, какие страницы и разделы они могут сканировать и индексировать, а какие — нет. Например, если у вас есть страницы с конфиденциальной информацией или дублирующимся контентом, вы можете запретить их индексацию с помощью этого файла.

Вот как может выглядеть простой файл robots.txt:

plaintext

Копировать код

User-agent: *

Disallow: /admin/

Allow: /public/

Sitemap: https://www.example.com/sitemap.xml

Этот пример говорит всем поисковым роботам (обозначение User-agent: *), что им запрещено сканировать каталог /admin/, но доступ к /public/ разрешён. Также файл содержит ссылку на карту сайта, которая помогает роботам быстро находить страницы для индексации.

Почему robots.txt так важен для SEO?

На первый взгляд, файл robots.txt может показаться мелочью, но он имеет значительное влияние на SEO вашего сайта. Рассмотрим ключевые преимущества его использования:

1. Контроль над индексацией

Ваша цель — сделать так, чтобы в поисковых системах отображались только те страницы, которые действительно важны для пользователей. Например, страницы корзины, администраторские панели или тестовые разделы лучше скрыть от индексации, чтобы они не занимали места в поисковой выдаче и не создавали путаницы.

2. Оптимизация краулингового бюджета

Поисковые системы выделяют вашему сайту ограниченное количество времени для сканирования — это так называемый краулинговый бюджет. Если роботы тратят его на неважные страницы, важные разделы могут остаться без внимания. Файл robots.txt помогает направить роботов туда, где они действительно нужны.

3. Улучшение безопасности

Хотя файл robots.txt не защищает страницы от доступа напрямую, он может скрыть административные или конфиденциальные разделы от глаз поисковых систем. Например, запрет сканирования страниц авторизации снижает риск их появления в поисковой выдаче.

4. Ускорение индексации важных страниц

С помощью файла robots.txt вы можете указать путь к карте сайта (Sitemap), что помогает поисковым системам быстрее находить и индексировать нужные страницы.

Основные директивы в robots.txt

Чтобы использовать robots.txt эффективно, нужно понимать его основные директивы:

- User-agent

Указывает, к какому поисковому роботу применяются правила. Например, User-agent: Googlebot применяет правила только к роботу Google.

- Disallow

Запрещает сканирование указанного пути. Например, Disallow: /private/ скроет папку /private/.

- Allow

Разрешает сканирование определённых страниц или файлов, даже если более общий запрет их охватывает.

- Sitemap

Указывает путь к файлу Sitemap, что помогает роботам найти все страницы, доступные для индексации.

Примеры настройки файла robots.txt

Для интернет-магазина

Вы можете скрыть страницы корзины, оформления заказа и администраторскую панель:

plaintext

Копировать код

User-agent: *

Disallow: /cart/

Disallow: /checkout/

Disallow: /admin/

Sitemap: https://www.mystore.com/sitemap.xml

Для блога

Если вы хотите скрыть черновики и папки с изображениями:

plaintext

Копировать код

User-agent: *

Disallow: /drafts/

Disallow: /images/

Allow: /images/icons/

Sitemap: https://www.myblog.com/sitemap.xml

Для крупного портала

Чтобы направить роботов только на ключевые разделы:

plaintext

Копировать код

User-agent: *

Disallow: /

Allow: /news/

Allow: /articles/

Sitemap: https://www.bigportal.com/sitemap.xml

Рекомендации по настройке robots.txt

- Будьте осторожны с директивами Disallow

Неправильная настройка может привести к тому, что поисковые системы перестанут индексировать важные страницы. Например, запрет на / полностью заблокирует сканирование сайта.

- Регулярно проверяйте файл

Если вы изменили структуру сайта, не забудьте обновить robots.txt. Старые правила могут привести к путанице.

- Используйте инструменты тестирования

Google Search Console и другие сервисы помогут проверить, как поисковые роботы воспринимают ваш файл robots.txt.

- Не используйте robots.txt для защиты данных

Этот файл виден любому пользователю, поэтому для защиты конфиденциальной информации лучше использовать другие методы, такие как пароли или файлы .htaccess.

Как robots.txt помогает вашему SEO

Файл robots.txt — это фундамент технической оптимизации сайта. Он помогает сосредоточить ресурсы поисковых систем на ключевых страницах, избегать дублирования контента и ускорять процесс индексации. Для крупных сайтов с большим количеством страниц это особенно важно: правильная настройка может значительно улучшить их видимость в поисковой выдаче.

Если вы хотите добиться максимальных результатов и ускорить продвижение вашего сайта, стоит обратиться к профессионалам. SEO-агентство «Оптимизм» предлагает полный спектр услуг, включая техническую оптимизацию, настройку SEO, а также стратегическое продвижение сайта, которое поможет вам повысить его позиции и привлечь больше посетителей.

Теги публикации: robots.txt, Как оптимизировать robots.txt, оптимизация robots.txt, продвижение сайта

Такой подход позволяет увеличить спрос и снизить стоимость каждого клиента

Оптимизация сайта под максимально широкий пул ключевых запросов

Вид поискового продвижения, при котором оплата производится за целевые действия