[Идеальный аудит сайта] Шаг №5: индексация сайта, noindex, nofollow, seohide, ошибки robots.txt и sitemap.xml

*Публикация написана в рамках цикла статей про “Идеальный аудит сайта”.

Как только вы наладили сайт, чтобы он корректно собирал хостовые факторы, следует проверить индексацию.

Проверка и оптимизация индексации сайта — ключевой элемент успешной SEO-стратегии. В данной статье мы разберём методы и инструменты, которые анализируют состояние индексации страниц, их доступность для поисковых роботов, корректность настроек в файлах robots.txt и sitemap.xml и многое другое.

Индексация сайта в поисковых системах — добавление информации о сайте в базу поисковых систем. Это напоминает внесение информации в каталог библиотеки. Информация вносится специалистами, а за её проверку и обработку отвечают поисковые роботы — алгоритмы.

1. Как проверить индексацию сайта в каждой странице

- Ручная проверка через Google. Введите в поиск Google запрос типа «site:yourwebsite.com/yourpage». Если ваша страница отобразится, значит она индексирована.

- Сервисы третьих сторон. Ahrefs, SEMrush или Moz предоставляют подробные данные и широкий набор функций.

- Проверка файла robots.txt. Убедитесь, что ваш файл robots.txt не блокирует индексацию страниц, которые вы хотите видеть в поисковых системах. Файл robots.txt расположен по адресу «yourwebsite.com/robots.txt».

- Проверка мета-тегов. Ваш сайт или страницы могут содержать мета-теги, которые указывают поисковым системам не индексировать их. Проверьте код сайта на наличие тегов <meta name=”robots” content=”noindex”> или <meta name=”googlebot” content=”noindex”>.

Если страница не индексируется, это может быть вызвано несколькими причинами: проблемами с сервером, директивами noindex, слишком большим временем загрузки страницы и др.

2. Как создать список непроиндексированных страниц, которые посещал поисковый алгоритм

Для создания такого списка используйте Google Search Console (GSC) и лог-файлы сервера.

Google Search Console

- Войдите в свой аккаунт GSC.

- Выберите ваш сайт.

- Перейдите в раздел «Coverage» или «Покрытие».

- Изучите разделы «Excluded» (исключенные) и «Valid with warnings» (верные с предупреждениями).

- Здесь вы найдете страницы, которые Google посетил, но по той или иной причине не проиндексировал.

- Экспортируйте эти данные в CSV-файл для дальнейшего анализа и управления списком.

Анализ лог-файлов сервера

- Лог-файлы сервера содержат информацию о каждом запросе, сделанном к серверу, включая запросы от поисковых ботов. Вы можете проанализировать эти лог-файлы с помощью Screaming Frog Log File Analyser и увидеть, какие страницы посетил Googlebot.

- Сопоставьте этот список страниц с индексированными страницам, например, используя информацию из GSC или запрос «site:yourwebsite.com» в Google. Так вы увидите, какие страницы не были проиндексированы.

Помните, что многие факторы влияют на индексацию страниц: настройка robots.txt, мета-теги noindex, время загрузки страницы, структура сайта и многое другое. Если у вас есть страницы, которые не индексируются, начните с анализа этих факторов.

3. Как проверить возможность индексации важных областей на flash и ajax сайтах

Flash и AJAX могут затруднять обнаружение и индексацию содержимого страницы. Мы собрали несколько методов, которые решат эту проблему:

- Проверка исходного кода страницы. Поскольку поисковые системы читают исходный код страницы, это хороший способ увидеть, что они могут и не могут увидеть. В браузере нажмите правой кнопкой мыши на страницу и выберите «Просмотреть код страницы» или «Исследовать элемент» (в зависимости от браузера).

- Использование инструментов для веб-разработчиков. Браузеры Chrome и Firefox имеют встроенные инструменты, которые анализируют структуру страницы и выделяют, какие элементы могут быть индексированы.

- Проверка файлов robots.txt и sitemap.xml. Эти файлы сообщают поисковым системам, какие страницы и файлы на вашем сайте должны быть проиндексированы. Убедитесь, что важные области сайта не заблокированы в файле robots.txt и включены в файл sitemap.xml.

- Разработка версии сайта без использования Flash и AJAX. Это подойдёт, если вы замечаете, что Flash или AJAX мешают индексации сайта. HTML5 предоставляет множество функций, которые ранее требовали использования Flash, и современные методы разработки сайтов позволяют создавать интерактивные и динамичные сайты без использования AJAX.

Какие страницы нужно индексировать, а какие не нужно:

Обратите внимание, что в 2017 году Google объявил о планах полностью прекратить поддержку Flash к концу 2020 года. Поэтому, если ваш сайт по-прежнему активно использует Flash, рекомендуется перейти на альтернативные технологии.

Что касается AJAX, Google и другие поисковые системы продолжают улучшать способы обхода и индексации сайтов, использующих AJAX. Однако могут возникать сложности с полной индексацией таких сайтов. Google предложил несколько руководств по созданию сайтов, дружественных к AJAX, которые могут быть полезными в этом процессе.

4. Как проверить возможность индексации всех страниц сайта при текущих инструкциях robots.txt

Файл robots.txt даёт инструкции поисковым системам о том, какие страницы и директории сайта они должны или не должны сканировать и индексировать. Чтобы проверить, как текущие инструкции в файле robots.txt влияют на индексацию всех страниц сайта, вы можете следовать следующим шагам:

- Просмотрите свой файл robots.txt. Для большинства сайтов файл robots.txt доступен по адресу www.yourwebsite.com/robots.txt. Проверьте его содержимое и убедитесь, что важные страницы и директории не заблокированы для поисковых систем.

- Проверьте индексацию вашего сайта в Google. Введите в Google запрос site:yourwebsite.com и убедитесь, что все важные страницы сайта отображаются в результатах поиска. Если какие-то страницы отсутствуют, их может блокировать файл robots.txt.

- Используйте SEO-инструменты. Screaming Frog, SEMrush и Ahrefs могут анализировать файл robots.txt и выявлять проблемы с индексацией на сайте.

Помните, что robots.txt — всего лишь один из многих факторов, которые влияют на индексацию. Если какие-то страницы не индексируются, стоит проверить и другие возможные причины: мета-теги noindex, ошибки сервера, дублирование контента, медленную загрузку страницы и т.д.

5. Проверка целесообразности использования <noindex>, nofollow, meta noindex, meta nofollow, SEOHide

Директивы <noindex>, nofollow, meta noindex, meta nofollow, и SEOHide используются для контроля над тем, как поисковые системы взаимодействуют с вашим сайтом. Их применение может быть целесообразно в зависимости от конкретных целей SEO. Вот некоторые методы, которые помогут это проверить:

- Использование SEO-инструментов. Screaming Frog, SEMrush, Ahrefs и Moz выявляют, где и как используются эти директивы на вашем сайте.

- Ручной аудит. В браузере нажмите правую кнопку мыши на веб-странице и выберите «Просмотреть код элемента» или «Исследовать элемент». Затем поищите теги <meta name=”robots” content=”noindex”>, <meta name=”robots” content=”nofollow”> или любые другие специфичные директивы.

Теперь по поводу целесообразности:

- noindex. Указывает поисковым системам не индексировать определённые страницы. Это полезно, если у вас есть страницы, которые вы не хотите видеть в результатах поиска: страницы администрирования, страницы благодарности за подписку и т.д.

- nofollow. Указывает поисковым системам не следовать по ссылкам на определённые страницы. Пригодится, если вы не хотите передавать «сок» ссылки на сайты с низким качеством или страницы, которые не относятся к вашему сайту.

- meta noindex и meta nofollow. Это по сути те же самые директивы, что и noindex и nofollow, только они добавляются в мета-теги страницы.

- SEOHide. Cвоеобразный мета-тег, используемый некоторыми CMS и SEO-плагинами, чтобы скрыть какие-то части страницы от поисковых систем. Стоит быть осторожнее с его использованием — поисковые системы могут воспринять его как попытку манипулировать результатами поиска.

Директивы полезны, но их неправильное использование может привести к проблемам с SEO. Поэтому важно регулярно проверять их.

6. Как проверить корректность использования <noindex>, nofollow, SEOHide

Проверка корректности использования <noindex>, nofollow и SEOHide включает в себя анализ страниц сайта. Цель — убедиться, что эти директивы используются там, где они действительно необходимы, и не используются там, где они могут негативно сказаться на SEO. Вот несколько шагов, которые вы можете предпринять:

- Проверьте использование noindex и nofollow. Откройте исходный код страницы и поищите там мета-теги <meta name=”robots” content=”noindex”> и <meta name=”robots” content=”nofollow”>. Если эти теги присутствуют на страницах, которые должны быть индексированы и переходить на другие страницы, это может стать проблемой. С другой стороны, если эти теги отсутствуют на страницах, которые не должны быть индексированы или переходить на другие страницы (например, страницы администратора, страницы благодарности и т. д.), это также может стать проблемой.

- Проверьте использование SEOHide. В зависимости от CMS или SEO-плагина, который вы используете, директива SEOHide может быть добавлена в мета-теги страницы или как атрибут к определённым элементам. Если она используется для скрытия важного контента, это может негативно сказаться на SEO. Если она используется для скрытия ненужного или дублирующего контента, это, скорее всего, положительно повлияет на SEO.

- Используйте инструменты аудита SEO. Screaming Frog, SEMrush, Ahrefs и Moz выявят, где и как используются эти директивы на сайте. Это особенно полезно, если у сайта много страниц.

- Проверьте индексацию в Google. Введите в Google запрос site:yourwebsite.com и убедитесь, что все важные страницы сайта отображаются в результатах поиска. Если какие-то страницы отсутствуют, это может быть связано с использованием noindex или SEOHide.

Помните, что нарушения SEO могут быть сложными и многофакторными, и исправление одной проблемы не решит их все. Регулярный аудит сайта и постоянное совершенствование стратегии SEO — ключ к успеху.

7. Как найти ошибки при сравнении индексов по категориям и типам страниц

Если количество индексированных страниц в разных поисковых системах различается для определённых разделов и типов страниц, это указывает на наличие проблем с определёнными элементами вашего сайта. Вот несколько стратегий, которые помогут вам:

- Поиск отсутствующих страниц. Самый простой способ начать — сравнить списки индексированных страниц в разных поисковых системах и поискать страницы, которые отсутствуют в одном из списков. Какие это могут быть страницы:

- которые заблокированы для одной поисковой системы, но не заблокированы для другой;

- страницы, которые по какой-то причине не могут быть проиндексированы одной из поисковых систем.

- Проверьте файлы robots.txt. Убедитесь, что инструкции в вашем файле robots.txt не блокируют индексацию страниц, которые должны быть индексированы. Некоторые поисковые системы чувствительнее к инструкциям в файле robots.txt, чем другие.

- Проверьте мета-теги и заголовки. Мета-теги и заголовки играют важную роль в том, как поисковые системы индексируют и ранжируют ваши страницы. Если определённые мета-теги или заголовки отсутствуют или неправильно форматированы, это влияет на индексацию.

- Использование инструментов SEO. SEMrush, Ahrefs и Moz анализируют проиндексированные страницы в разных поисковых системах и ищут различия.

- Проверка наличия ошибок 404 и 301. Ошибки 404 (страница не найдена) или 301 (постоянное перенаправление) влияют на индексацию страниц в разных поисковых системах.

- Проверка наличия дублирования контента. Некоторые поисковые системы строже, чем другие по отношению к дублированию контента. Это влиятет на то, какие страницы они индексируют.

Пример изучения областей сайта, где в одной ПС страниц меньше, чем в другой:

Устранение ошибок и оптимизация сайта для всех поисковых систем, а не только для одной, поможет увеличить трафик и улучшить общую видимость сайта.

8. Как найти в индексе технические страницы

Технические страницы не индексируются поисковыми системами, поскольку они не представляют собой особого интереса для пользователей и не содержат полезного контента. Такие страницы могут включать страницы административного интерфейса, страницы логина или формы. Важно, чтобы они страницы не были проиндексированы — их присутствие в результатах поиска негативно влияет на SEO.

Если вы хотите проверить, проиндексированы ли эти страницы, вот несколько шагов, которые вы можете предпринять:

- Запросы в Google. Вы можете выполнить запрос в Google, используя оператор site:. Так вы увидите, какие страницы сайта проиндексированы. Например, site:yourwebsite.com/login покажет, индексирует ли Google страницу логина.

- Использование инструментов SEO. SEMrush, Ahrefs и Moz анализируют проиндексированные страницы сайта и идентифицируют потенциальные проблемы.

Если вы обнаружите, что технические страницы сайта были проиндексированы, вы должны обновить файл robots.txt или добавить мета-тег noindex на эти страницы. Это предотвратит их индексацию поисковыми системами. После этого отправьте запрос на повторное индексирование в Google Search Console, чтобы убедиться, что эти изменения были учтены.

9. Анализ динамики индексации сайта

Анализ динамики индексации сайта важен для понимания, как поисковые системы видят и интерпретируют ваш сайт. Он выявит проблемы и покажет, какие изменения на сайте положительно влияют на индексацию. Вот, как вы можете провести анализ:

- Соберите исторические данные. Попробуйте собрать исторические данные о количестве проиндексированных страниц.

- Анализируйте покрытие. Посмотрите, какие страницы проиндексированы, какие заблокированы и какие вызвали ошибки. Анализ этих данных покажет, какие области сайта нуждаются в улучшении.

- Проверьте технические аспекты. Убедитесь, что ваш файл robots.txt правильно настроен, и что ваши страницы не заблокированы для индексации. Проверьте мета-теги на наличие инструкций noindex, которые могут предотвращать индексацию.

- Отслеживайте изменения на сайте. Запишите все значительные изменения на сайте: перенос сайта, изменения в навигации, добавление или удаление больших количеств страниц.

- Используйте SEO-инструменты. SEMrush, Ahrefs и Moz автоматизируют многие из этих задач, предоставляя регулярные отчёты и анализ индексации сайта.

- Сравните с конкурентами. Если возможно, сравните динамику индексации сайта с конкурентами в вашей отрасли. Так вы поймёте, является ли ваша индексация нормальной для вашей отрасли.

- Анализируйте влияние на трафик. Посмотрите, как изменения в индексации коррелируют с изменениями в трафике. Это покажет, как индексация влияет на видимость сайта в поиске.

- Реагируйте на проблемы. Если вы обнаружите проблемы или неожиданные изменения в динамике индексации, реагируйте на них быстро, корректируя настройки сайта или ища технические проблемы, которые могут мешать индексации.

- Создайте регулярные отчёты. Они помогут легко отслеживать изменения и быстро на них реагировать.

Анализ динамики индексации — сложный процесс, но он жизненно важен для понимания, как ваш сайт виден поисковыми системами.

10. Как проверить robots.txt на ошибки

Файл robots.txt сообщает поисковым роботам, какие страницы или разделы веб-сайта следует индексировать или игнорировать. Вот как вы можете проверить файл robots.txt на ошибки:

- Проверка синтаксиса. Файл robots.txt должен быть написан в определённом формате и синтаксисе. Например, “Disallow: /” будет указывать на то, что все страницы сайта не должны индексироваться. Неправильно написанные команды или опечатки вызывают проблемы.

- Проверьте местоположение файла. Файл robots.txt всегда должен быть в корневом каталоге сайта. Если он размещён в другом месте, поисковые роботы не смогут его найти. Убедитесь, что его можно найти по адресу yourwebsite.com/robots.txt.

- Проверка специфичности инструкций. Убедитесь, что инструкции, прописанные в файле robots.txt, корректно указывают на конкретные страницы или директории, которые вы хотите заблокировать. Неправильно написанные пути приведут к блокировке большего количества страниц.

- Использование онлайн-инструментов. Robots.txt Checker и Robots.txt Validator ищут ошибки в файле robots.txt.

- Проверьте, не заблокированы ли важные страницы. Если страницы или ресурсы, необходимые для правильного отображения сайта, заблокированы в файле robots.txt, это негативно скажется на его ранжировании.

Помните, что после внесения любых изменений в файл robots.txt, необходимо отправить его на повторную индексацию через Google Search Console, чтобы убедиться, что Google обработает эти изменения.

11. Как проверить robots.txt на полноту данных

Проверка файла robots.txt на полноту данных покажет, что все нужные для сайта директории и файлы корректно упомянуты и их доступ настроен правильно. Вот как это сделать:

- Основные правила. Убедитесь, что файл содержит базовые директивы User-agent и Disallow. “User-agent: *” означает, что все последующие правила применимы ко всем поисковым роботам. “Disallow: /” означает, что все страницы сайта не должны индексироваться, поэтому если ваша цель — индексация сайта, этой директивы быть не должно. Если вы хотите исключить конкретные страницы или разделы, укажите их после “Disallow:”, например, “Disallow: /private/”.

- Конкретные директории и файлы. Если у вас есть специфические директории или файлы, которые вы хотите заблокировать от индексации, убедитесь, что они перечислены в файле. Например, если у вас есть директория с изображениями, которую вы не хотите индексировать, убедитесь, что она указана в директиве Disallow.

- Директива Allow. Не забудьте, что вы также можете использовать директиву Allow для указания тех страниц или директорий, которые должны быть проиндексированы, даже если они находятся в директории, указанной в Disallow.

- Sitemap. Важно указать в robots.txt расположение файла карты сайта (Sitemap), чтобы поисковые роботы знали, где найти его. Это делается с помощью директивы Sitemap, например, Sitemap: https://домен.ру/sitemap.xml.

- Проверьте формат. Каждая директива должна находиться на новой строке и быть записанной в правильном формате. Неправильное форматирование может привести к тому, что поисковые роботы проигнорируют директивы.

- Наличие мусорных записей. Убедитесь, что нет никаких записей, которые не относятся к текущей структуре вашего сайта. Например, старые или удалённые пути, которые больше не существуют.

Убедитесь, что robots.txt включает в себя все нужные вам блоки и пути, и то, что они правильно записаны. Помните, что файл robots.txt может быть различным для разных сайтов в зависимости от их структуры и целей. Всегда стоит периодически пересматривать файл robots.txt — он всегда должен быть актуальным.

12. Как проверить robots.txt на наличие директив для всех поисковых систем

Файл robots.txt может содержать директивы для разных поисковых систем. Проверка на наличие таких директив можно выполнить следующим образом:

- Общие директивы. Директивы, применяемые ко всем поисковым системам, начинаются с User-agent: *”. Проверьте, что у вас есть такие общие директивы, которые должны быть применимы ко всем поисковым системам.

- Специфические директивы. Если вы хотите указать директивы, которые применимы только к определённой поисковой системе, вы должны использовать User-agent: [имя поисковой системы]. Например, User-agent: Googlebot или User-agent: Bingbot. Проверьте, что у вас есть директивы для всех важных поисковых систем.

- Проверьте директивы. После каждого указания User-agent вы должны указать директивы Disallow или Allow, которые применимы к этому поисковому боту. Убедитесь, что эти директивы указаны и форматированы правильно.

- Проверьте на наличие ошибок. Используйте инструмент для тестирования robots.txt, например, тот, который предлагает google search console. Он поможет вам проверить файл на наличие ошибок и увидеть, как различные поисковые боты будут интерпретировать директивы.

- Учтите специфические директивы для некоторых поисковых систем. Например, Яндекс, поддерживает директивы, которые не поддерживаются другими поисковыми системами (Clean-param, Host и т.д). Убедитесь, что вы включили все необходимые специфические директивы.

Хотя файл robots.txt служит указанием для поисковых систем о том, какие страницы было бы желательно пропустить при индексации, стоит помнить, что это лишь совет, не обязательный к выполнению. Более того, не все поисковые системы строго придерживаются этих рекомендаций.

13. Как проверить актуальность robots.txt

Robots.txt сообщает поисковым ботам, какие страницы или части сайта следует индексировать, а какие следует игнорировать. Чтобы проверить актуальность файла robots.txt, выполните следующее:

- Проверьте наличие файла robots.txt. Убедитесь, что у вас на самом деле есть файл robots.txt на сайте. Чтобы это сделать, просто добавьте /robots.txt к URL вашего сайта, например, www.example.com/robots.txt.

- Прочтите содержимое файла. Посмотрите, что находится в файле robots.txt. Несмотря на то, что это просто текстовый файл, он может содержать важную информацию для поисковых ботов. В частности, смотрите на директивы Disallow, которые указывают, какие страницы или папки ботам следует игнорировать.

- Используйте инструмент для проверки robots.txt. Используйте, например, «Проверку файла robots.txt» в Google Search Console, чтобы проверить и проанализировать файл robots.txt. Этот инструмент покажет, какие страницы блокируются для Googlebot, и поможет определить, нужно ли обновить файл.

- Проверьте актуальность информации. Сравните содержимое файла robots.txt с текущей структурой сайта. Если были внесены изменения в структуру сайта или были добавлены новые страницы, которые необходимо заблокировать или разблокировать для индексации, следует обновить файл robots.txt.

- Проверьте правильность синтаксиса. Убедитесь, что все директивы в файле robots.txt написаны правильно. Ошибки в синтаксисе могут привести к неправильной индексации сайта.

- Проверьте ссылку на карту сайта. Файл robots.txt должен содержать ссылку на карту сайта в формате XML. Это поможет поисковым ботам легче найти и индексировать страницы на сайте. Если ссылка отсутствует или неактуальна, её нужно обновить.

Наконец, после проведения всех проверок и внесения необходимых изменений, убедитесь, что файл robots.txt доступен для поисковых ботов и не заблокирован на уровне сервера.

14. Как проверить sitemap.xml на ошибки

Sitemap.xml помогает поисковым движкам понять структуру сайта и индексировать его страницы. Чтобы проверить sitemap.xml на ошибки, сделайте следующее:

- Проверьте наличие файла sitemap.xml. По умолчанию файл sitemap.xml обычно находится в корневом каталоге сайта. Вы можете проверить его наличие, перейдя по URL-адресу сайта, к которому добавлен /sitemap.xml, например, www.example.com/sitemap.xml.

- Визуальная проверка файла. Откройте файл sitemap.xml и просмотрите его содержимое. Проверьте, правильно ли отформатированы ссылки, нет ли битых ссылок, и правильно ли указаны приоритеты страниц.

- Использование инструментов проверки карты сайта. Google Search Console и Bing Webmaster Tools предоставляют возможности для загрузки и проверки файла sitemap.xml. Эти инструменты определяют ошибки: недоступные страницы, ошибки в синтаксисе и другие проблемы.

- Использование валидаторов XML. Существуют валидаторы XML (например, XML Sitemap Validator), которые позволяют проверить файл на наличие синтаксических ошибок. Проверьте файл sitemap.xml с помощью такого валидатора, чтобы убедиться, что он не содержит ошибок.

- Проверка включения всех необходимых страниц. Убедитесь, что в файле sitemap.xml включены все важные страницы сайта, которые должны быть проиндексированы. Если какие-то страницы отсутствуют, внесите соответствующие изменения в файл.

- Проверьте даты последнего изменения. В файле sitemap.xml есть дата последнего изменения для каждой страницы. Убедитесь, что эти даты актуальны, особенно если вы недавно обновляли содержимое своего сайта.

В случае обнаружения любых ошибок после проведения вышеупомянутых проверок, важно незамедлительно их устранить. После этого следует загрузить обновленный файл sitemap.xml в выбранные вами инструменты для вебмастеров. Это обеспечит корректную индексацию сайта поисковыми системами.

15. Как провести анализ расстановки дат индексации и приоритетов в sitemap.xml

Расстановка дат индексации и приоритетов в sitemap.xml играет важную роль в общем SEO сайта. Вот несколько шагов, которые вы можете предпринять для анализа этих параметров:

- Проверка даты последнего обновления страниц. В файле sitemap.xml для каждой веб-страницы указывается дата последнего обновления. Это помогает поисковым системам понять, когда были внесены последние изменения в контент. Убедитесь, что эти даты актуальны и соответствуют времени последнего обновления контента на соответствующих страницах.

- Анализ приоритета страниц. В файле sitemap.xml вы можете установить приоритетность страниц относительно друг друга. Значение приоритета должно быть между 0.0 и 1.0. Это поможет поисковым системам понять, какие страницы на сайте более важны. Однако, стоит помнить, что Google официально заявил, что он не обращает внимания на этот параметр в sitemap. Тем не менее другие поисковые системы могут его учитывать.

- Определение частоты изменения страниц. В файле sitemap.xml можно указать частоту изменения страницы. Это поможет поисковым системам понять, насколько часто они должны переиндексировать каждую страницу. Это не обязательный параметр, и поисковые системы могут его игнорировать, опираясь на свои внутренние алгоритмы.

- Использование аналитических инструментов. Использование инструментов веб-аналитики покажет, какие страницы на сайте важны для посетителей. Так вы поймёте, какие страницы должны иметь высший приоритет в файле sitemap.xml.

- Проверка актуальности. Обновляйте файл sitemap.xml регулярно, чтобы отражать любые изменения на сайте: добавление новых страниц, удаление старых или обновление существующего контента.

После проведения этого анализа, внесите любые необходимые изменения в файл sitemap.xml, чтобы убедиться, что он актуален и отражает наиболее важные страницы сайта для поисковых систем.

16. Проверка актуальности sitemap.xml

Схема сайта или sitemap.xml – файл, который помогает поисковым системам лучше понимать структуру сайта и облегчает индексацию. Вот как вы можете проверить актуальность sitemap.xml:

- Соответствие структуры сайта. Первым делом убедитесь, что все страницы сайта присутствуют в sitemap.xml. Если были внесены изменения в структуру сайта или добавлены новые страницы, они должны быть отражены в sitemap.xml.

- Проверка ошибок. С помощью «Яндекс.Вебмастера» можно проверить наличие ошибок в sitemap.xml. Эти инструменты выявят и устранят ошибки в кодировке, ссылках, тегах и т.д.

- Проверка дат последнего обновления. Даты последнего обновления (если они указаны в sitemap) должны соответствовать реальным датам обновления страниц. Если дата в sitemap.xml более старая, чем фактическая дата обновления страницы, это может замедлить её индексацию.

- Удаление лишних ссылок. Проверьте, нет ли в sitemap.xml ссылок на страницы, которые не должны индексироваться (страницы с ошибками, временные страницы, дубликаты и т. д.). Включение таких ссылок может негативно повлиять на индексацию сайта.

- Проверка актуальности sitemap.xml с помощью инструментов для SEO. Например, Screaming Frog автоматизирует и упрощает процесс проверки актуальности sitemap.xml.

После всех этих проверок и исправлений убедитесь, что обновленный sitemap.xml загружен на сервер и доступен для поисковых систем.

17. Поиск запрещённых к индексации страниц в sitemap.xml

Найти запрещенные к индексации страницы в sitemap.xml можно с помощью нескольких шагов:

- Используйте SEO-инструменты. Screaming Frog или SEMRush собирают данные о каждой странице, включая информацию о том, доступна ли страница для индексации или нет.

- Проверьте файл robots.txt. Файл robots.txt может содержать инструкции, которые запрещают индексацию определённых страниц или директорий. Убедитесь, что никакие важные страницы не блокируются.

- Проверьте мета-теги robots на каждой странице. Мета-теги robots используются для управления индексацией отдельных страниц. Проверьте код каждой страницы на наличие тегов, таких как <meta name=”robots” content=”noindex”>.

- Используйте Google Search Console. Здесь есть функция «Покрытие», которая покажет, какие страницы были проиндексированы, какие были заблокированы роботом, и будут ли какие-либо ошибки.

После того как вы найдете страницы, которые запрещены для индексации, убедитесь, что они не включены в sitemap.xml. Если они там, это может привести к конфузии и ошибкам при попытках индексации поисковыми системами.

Также помните, что некоторые страницы могут быть специально исключены из индексации, например, страницы с личной информацией, страницы благодарности после отправки формы и т.д. Это нормальная практика и не требует исправлений.

Итог

Мы прошли долгий путь, разбирая аспекты индексации и доступности сайта. Освоение этих процессов является важным шагом в оптимизации сайта. Надеемся, что данная статья помогла вам разобраться в этих вопросах, и вы сможете эффективно применять полученные знания на практике.

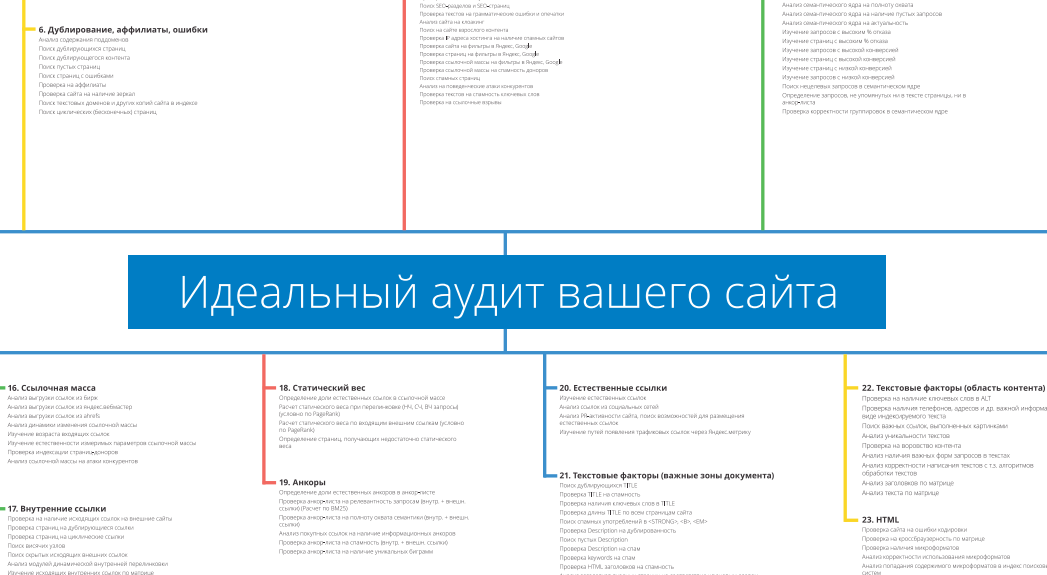

На следующем этапе SEO-аудита нужно убрать дублирование, аффилиаты и ошибки.

Как поднять сайт в топ: рекомендации от SEO-агентства «Оптимизм»

Индексация сайта в Яндексе. Как проверить?

- Воспользуйтесь поисковой системой Яндекс, введя запрос в формате site:вашсайт.com (где «вашсайт.com» — домен вашего сайта). В результате вы увидите страницы вашего сайта, которые Яндекс уже проиндексировал.

- «Яндекс.Вебмастер» предоставляет детальную информацию о статусе индексации вашего сайта в Яндексе. После регистрации или входа на сайт «Яндекс.Вебмастер», вы можете добавить свой сайт и в личном кабинете просмотреть раздел «Индексирование». Здесь отображается информация о количестве проиндексированных страниц и другие данные, касающиеся состояния индексации вашего веб-ресурса.

- Убедитесь, что ваш файл robots.txt не блокирует индексацию ключевых страниц. Через «Яндекс.Вебмастер» можно проверить, правильно ли настроен ваш файл и не создаёт ли он препятствий для индексации.

- В «Яндекс.Вебмастер» также могут приходить уведомления о проблемах с индексацией или другими аспектами сайта. Регулярно проверяйте раздел «Сообщения» на наличие важных уведомлений.

Влияет ли количество непроиндексированных страниц на продвижение?

- Количество непроиндексированных страниц само по себе не влияет на ранжирование сайта в поисковых системах. Однако непроиндексированные страницы и их причины могут говорить о некоторых проблемах на вашем сайте, которые могут косвенно влиять на продвижение. Рассмотрим, каким образом:

- Если множество важных страниц не проиндексированы, это указывает на технические ошибки сайта: проблемы с файлом robots.txt, директивами noindex или ошибками сервера. Такие проблемы негативно сказываются на общем впечатлении поисковых систем о качестве сайта.

- Если определённые страницы не проиндексированы из-за низкого качества или дублированного контента, это сказывается на репутации вашего сайта в алгоритмах поисковых систем.

- Плохая навигация или отсутствие внутренних ссылок затрудняет процесс индексации. В итоге, некоторые важные страницы не попадают в индекс, что уменьшит видимость сайта в результатах поиска.

- Если мобильная версия вашего сайта имеет проблемы с индексацией, это негативно влияет на ранжирование, учитывая, что многие поисковые системы, включая Google, используют мобильный индекс как основной.

Почему сайт не индексируется в Google? Ёмкий ответ одного из SEO-специалистов:

Подведём итог и сконцентрируем все рассмотренные выше этапы, которые включает в себя индексация сайта:

- Проверка индексации каждой страницы сайта

- Составление списка непроиндексированных страниц, посещённых роботом.

- Проверка возможности индексации важных областей на flash и ajax сайтах.

- Проверка возможности индексации всех страниц сайта при текущих инструкциях robots.txt.

- Проверка целесообразности использования <noindex>, nofollow, SEOHide.

- Проверка корректности использования <noindex>, nofollow, SEOHide.

- Сравнение индексов по категориям и типам страниц.

- Поиск в индексе технических страниц.

- Анализ динамики индексации сайта.

- Проверка robots.txt на ошибки.

- Проверка robots.txt на полноту данных.

- Проверка robots.txt на наличие директив для всех поисковых систем.

- Проверка актуальности robots.txt.

- Проверка sitemap.xml на ошибки.

- Анализ расстановки дат индексации и приоритетов в sitemap.xml.

- Проверка актуальности sitemap.xml.

- Поиск запрещённых к индексации страниц в sitemap.xml.

| Скачайте PDF версию идеального аудита для самостоятельного продвижения или закажите аудит проекта и его продвижение у нашей команды:

Ознакомьтесь с преимуществами услуги и свяжитесь с нами. |

Теги публикации: nofollow, noindex, robots.txt, seo, seo-аналитика, seohide, sitemap.xml, анализ проекта, аудит сайта, идеальный аудит сайта, лайфхак, полезные советы

Такой подход позволяет увеличить спрос и снизить стоимость каждого клиента

Продвижение с оплатой за трафик

Оптимизация сайта под максимально широкий пул ключевых запросов

Вид поискового продвижения, при котором оплата производится за целевые действия

![[Идеальный аудит сайта] Шаг №5: индексация сайта, noindex, nofollow, seohide, ошибки robots.txt и sitemap.xml. nofollow, noindex, robots.txt, seo, seo-аналитика | от SEO, Полезное | nofollow, noindex, robots.txt, seo, seo-аналитика, seohide, sitemap.xml | от](https://optimism.ru/blog/wp-content/uploads/2023/05/5_hostovie_factory-3.png)

![[Идеальный аудит сайта] Шаг №5: индексация сайта, noindex, nofollow, seohide, ошибки robots.txt и sitemap.xml. nofollow, noindex, robots.txt, seo, seo-аналитика | от SEO, Полезное | nofollow, noindex, robots.txt, seo, seo-аналитика, seohide, sitemap.xml | от](https://optimism.ru/blog/wp-content/uploads/2023/05/screenshot_7.png)

![[Идеальный аудит сайта] Шаг №5: индексация сайта, noindex, nofollow, seohide, ошибки robots.txt и sitemap.xml. nofollow, noindex, robots.txt, seo, seo-аналитика | от SEO, Полезное | nofollow, noindex, robots.txt, seo, seo-аналитика, seohide, sitemap.xml | от](https://optimism.ru/blog/wp-content/uploads/2023/05/screenshot_8.png)

![[Идеальный аудит сайта] Шаг №5: индексация сайта, noindex, nofollow, seohide, ошибки robots.txt и sitemap.xml. nofollow, noindex, robots.txt, seo, seo-аналитика | от SEO, Полезное | nofollow, noindex, robots.txt, seo, seo-аналитика, seohide, sitemap.xml | от](https://optimism.ru/blog/wp-content/uploads/2023/05/oblasti-saita.jpg)

![[Идеальный аудит сайта] Шаг №5: индексация сайта, noindex, nofollow, seohide, ошибки robots.txt и sitemap.xml. nofollow, noindex, robots.txt, seo, seo-аналитика | от SEO, Полезное | nofollow, noindex, robots.txt, seo, seo-аналитика, seohide, sitemap.xml | от](https://optimism.ru/blog/wp-content/uploads/2023/05/screenshot_10.png)

![[Идеальный аудит сайта] Шаг №5: индексация сайта, noindex, nofollow, seohide, ошибки robots.txt и sitemap.xml. nofollow, noindex, robots.txt, seo, seo-аналитика | от SEO, Полезное | nofollow, noindex, robots.txt, seo, seo-аналитика, seohide, sitemap.xml | от](https://optimism.ru/blog/wp-content/uploads/2023/05/screenshot_11.png)