Фильтры Google — Penguin и Panda: как избежать и улучшить ранжирование вашего сайта

В этой статье мы рассмотрим, как работают фильтры Google — Penguin, Panda и не только. Разберем, как они влияют на ранжирование вашего сайта в поисковой выдаче. Объясним, почему эти механизмы могут налагать ограничения на сайт, и предложим проверенные методы, чтобы избежать или снять эти санкции.

Введение в поисковые алгоритмы: как работают системы Google

Поисковые алгоритмы Google — это комплексные математические формулы, используемые для сканирования, индексации и ранжирования веб-страниц. Они анализируют тысячи элементов на странице, включая контент, мета-теги, пользовательское поведение и внешние ссылки, чтобы определить, насколько полезной или релевантной будет страница для пользователя при определенном поисковом запросе.

Одной из ключевых задач алгоритмов Google является обеспечение высокого качества и релевантности результатов поиска. Google постоянно обновляет свои алгоритмы, чтобы бороться с SEO-манипуляциями и предоставлять пользователям наиболее полезные и актуальные результаты.

Обновления могут быть как незначительными, так и крупными, например, такие, как «Панда» (Panda) и «Пингвин» (Penguin). Они направлены на снижение ранга сайтов с низкокачественным контентом и ненатуральной ссылочной массой соответственно.

Важно понимать, что Google стремится предотвратить любые попытки манипулирования поисковой выдачей, чтобы исключить несправедливое преимущество и предоставить каждому сайту равные шансы на достижение видимости.

Для вебмастеров и SEO-специалистов крайне важно быть в курсе последних обновлений поисковых алгоритмов и адаптировать свои стратегии соответственно. Это включает в себя не только оптимизацию контента по актуальным требованиям, но и обеспечение хорошей пользовательской опытности, мобильной адаптивности и технической исправности сайта.

Регулярный аудит сайта, адаптация под мобильные устройства, улучшение скорости загрузки страниц и оптимизация структуры сайта могут существенно повысить шансы на успешное ранжирование в Google.

Раскрытие фильтров Google: что нужно знать каждому вебмастеру

Раскрытие фильтров Google — это критически важный аспект для каждого вебмастера, стремящегося оптимизировать свой сайт и избежать понижения его видимости в поисковой выдаче.

Фильтры Google представляют собой автоматические или ручные корректировки алгоритма поиска, направленные на устранение практик SEO-оптимизации, которые Google считает манипулятивными или низкокачественными. Например, фильтр «Панда» (Panda) нацелен на сайты с некачественным содержимым, повторяющимся или перенасыщенным ключевыми словами, в то время как «Пингвин» (Penguin) сосредотачивается на наказании за неестественные ссылочные профили.

Осознание того, как именно работают эти фильтры, позволяет вебмастерам лучше адаптироваться к требованиям Google и применять только белые методы SEO. Ключ к успешному избежанию фильтров — в создании качественного контента, который приносит реальную пользу аудитории.

Это означает отказ от избыточной оптимизации ключевыми словами и стремление к созданию уникального контента, который бы отвечал на вопросы и решал проблемы целевой аудитории. Важно также следить за профилем внешних ссылок, избегать покупных ссылок и стремиться к получению натуральных ссылок с авторитетных и тематически релевантных ресурсов.

Кроме того, важно регулярно проводить аудиты сайта, чтобы идентифицировать потенциальные проблемы, которые могут привести к применению санкций со стороны Google. Использование инструментов вроде Google Search Console, поможет вовремя обнаружить наличие ручных санкций и предоставить рекомендации по их устранению.

Понимание, какие изменения в алгоритмах происходят и как они могут повлиять на ваш сайт, позволит оперативно адаптироваться к изменяющимся условиям и поддерживать сайт в топе поисковой выдачи.

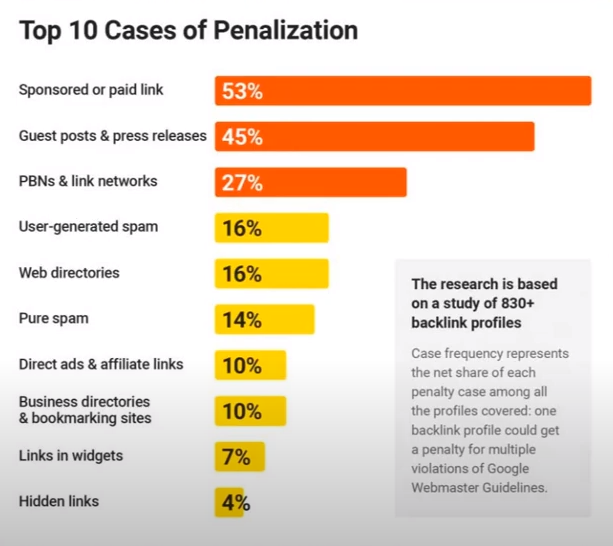

10 случаев санкций. Данные представлены на основе анализа более 830 профилей обратных ссылок.

Секреты обнаружения санкций: инструменты и методы проверки

Секреты обнаружения санкций, наложенных поисковой системой Google, начинаются с понимания того, какие инструменты и методы можно использовать для диагностики и мониторинга состояния вашего сайта.

Google Search Console (GSC) позволяет отслеживать, какие страницы индексируются, какие ошибки на сайте могут мешать индексации, и наличие ручных действий (санкций), принятых против сайта. Важно регулярно проверять раздел «Проблемы безопасности» в GSC, где указываются любые ручные санкции и рекомендации по их устранению.

Для того чтобы глубже понять, какие факторы могут влиять на ранжирование сайта, вебмастеры могут также использовать различные SEO-инструменты, которые предлагают анализ обратных ссылок, аудит контента и оценку здоровья сайта.

Инструменты помогают определить потенциально спорные области: неестественные паттерны ссылок или переоптимизация ключевых слов. Понимание этих аспектов критически важно для предотвращения автоматических санкций, особенно после значительных обновлений алгоритмов Google.

Наконец, не стоит игнорировать анализ поведенческих факторов и пользовательского опыта. Google Analytics помогает вебмастерам следить за тем, как пользователи взаимодействуют с сайтом.

Например, высокий процент отказов или короткое время пребывания на сайте могут быть индикаторами того, что контент сайта не соответствует ожиданиям пользователей, что, в свою очередь, может повлиять на ранжирование.

Регулярный мониторинг этих метрик и принятие мер для улучшения пользовательского опыта не только улучшит взаимодействие с сайтом, но и поможет избежать негативного влияния на ранжирование в результате алгоритмических изменений Google.

Путеводитель по ручным и автоматическим санкциям

Ручные и автоматические санкции от Google влияют на ранжирование сайтов в поисковой выдаче, но имеют различные причины и процедуры устранения. Ручные санкции накладываются специалистами Google после того, как они обнаруживают, что сайт нарушил рекомендации Google для вебмастеров. Такие санкции могут касаться конкретной страницы или всего сайта и часто связаны с серьёзными манипуляциями: скрытый текст, клоакинг или ненатуральная ссылочная масса.

Сведения о ручных санкциях можно найти в Google Search Console в разделе «Проблемы с безопасностью», где Google не только уведомляет о наложении санкций, но и предлагает рекомендации по их устранению. Устранение причин, вызвавших санкции, и последующая подача запроса на пересмотр могут привести к снятию ограничений.

Автоматические санкции, в свою очередь, являются результатом алгоритмических фильтров — «Панды» или «Пингвина». Эти алгоритмы автоматически обнаруживают и наказывают сайты за SEO-практики, которые считаются манипулятивными или низкокачественными: избыточное использование ключевых слов или искусственные ссылки.

Автоматические санкции обычно затрагивают большее количество сайтов и могут быть сняты только после того, как алгоритмы Google переоценят сайт при следующем обновлении, что может занять от нескольких недель до нескольких месяцев. Сайтам, подвергшимся автоматическим санкциям, необходимо провести глубокий аудит и корректировку SEO-стратегии, чтобы соответствовать текущим требованиям Google.

Для успешного восстановления после санкций крайне важно регулярно мониторить и анализировать все аспекты сайта. Вебмастерам рекомендуется тщательно проработать контент, обратные ссылки и пользовательский опыт.

После внесения исправлений, в случае ручных санкций, следует обратиться в Google с запросом на повторное рассмотрение. Такие действия показывают Google готовность к сотрудничеству и стремление к улучшению качества сайта, что может ускорить процесс снятия санкций.

Возрастные ограничения и их влияние на ранжирование

Возраст домена часто считается важным фактором в SEO, поскольку старшие домены могут восприниматься поисковыми системами как более авторитетные и надежные. Считается, что такие сайты накопили больше качественного контента и получили больше естественных обратных ссылок.

Однако простой факт длительного существования домена без поддержки качественного контента и хорошей пользовательской активности не гарантирует высокого ранжирования. Google и другие поисковые системы уделяют больше внимания качеству контента, пользовательскому опыту и другим SEO-факторам, чем просто возрасту домена.

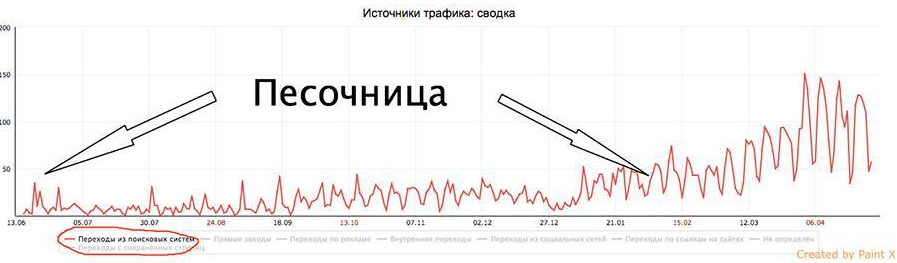

Для новых сайтов может быть труднее конкурировать с установленными сайтами сразу после запуска из-за так называемого фильтра «песочницы» Google. «Песочница» мешает новым сайтам появляться в высоких позициях поисковой выдачи, несмотря на наличие качественного контента и SEO-оптимизации.

Хотя Google не подтверждает существование песочницы как формального фильтра, многие SEO-специалисты считают, что новым сайтам требуется время, чтобы зарекомендовать себя и начать ранжироваться лучше.

Красные линии на графике – переход из поисковых систем.

Для работы с новыми сайтами важно сосредоточить усилия на создании качественного, уникального контента, который отвечает на запросы и потребности целевой аудитории.

Рекомендуется активно работать над наращиванием естественной ссылочной массы и социальных сигналов, которые ускорят процесс получения доверия от поисковых систем.

Также важно обеспечить техническую исправность сайта: скорость загрузки, мобильная адаптивность и безопасность (HTTPS) являются критически важными факторами, влияющими на пользовательский опыт и SEO.

Наконец, регулярный мониторинг и анализ результатов помогут определить наиболее эффективные стратегии и скорректировать их в соответствии с изменениями в алгоритмах поисковых систем и поведении пользователей.

Ссылочная архитектура и SEO: как избежать пенальти

Ссылочная архитектура играет ключевую роль в SEO, поскольку качество и количество входящих ссылок значительно влияют на ранжирование сайта. Однако не все ссылки одинаково полезны, и неправильное наращивание ссылочной массы может привести к пенальти от поисковых систем, особенно от Google. Разберемся в типах ссылочных фильтров и изучим лучшие практики наращивания качественной ссылочной массы, чтобы избежать возможных санкций.

Типы ссылочных фильтров:

- «Пингвин» — наказывает сайты, использующие ненатуральные ссылочные схемы, включая покупку ссылок, обмен ссылками и использование спамных или иррелевантных ссылок для искусственного повышения рейтинга сайта.

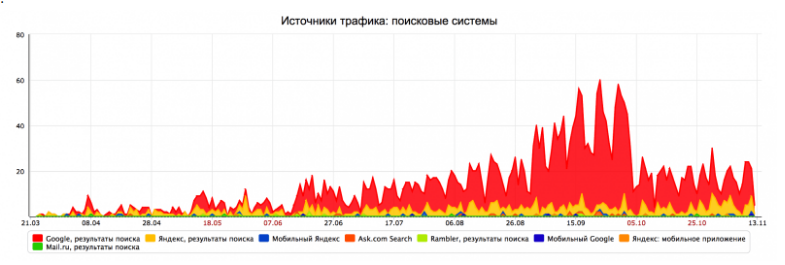

Как видно на графике, после начала автоматизированных закупок ссылок для компании N, трафик на сайт значительно снизился. Это связано с действием алгоритма Google Penguin 3.0, который целенаправленно понижает позиции сайтов, злоупотребляющих искусственным увеличением ссылочной массы и избыточным использованием ключевых слов в текстах ссылок. Этот фильтр разработан для борьбы с попытками манипулировать результатами поисковой выдачи через неестественные ссылочные стратегии.

- Спам-фильтр — применяет фильтры к сайтам, которые получают или размещают большое количество спамных ссылок. Это включает сайты, которые активно используют комментарии на форумах и блогах или директории со спамными, не относящимися к теме ссылками.

- Links — не принимает ссылки с сайтов низкого качества или с низким уровнем доверия. Это включает страницы с большим количеством исходящих ссылок, низким контентом или из регионов, известных высоким уровнем интернет-мошенничества.

Лучшие практики наращивания ссылочной массы:

Фокус на качестве, а не на количестве

Стремитесь получать ссылки с авторитетных, релевантных источников, которые естественным образом соотносятся с содержанием вашего сайта. Качественные ссылки из надежных источников значительно лучше множества низкокачественных ссылок.

Создание привлекательного и полезного контента

Натуральное получение ссылок — это результат публикации превосходного контента, которым хотят делиться. Инфографика, исследовательские статьи, блоги с глубоким погружением в тему и прочие виды контента, которые обеспечивают ценность читателям, способствуют получению качественных входящих ссылок.

Использование социальных сигналов

Активное присутствие и взаимодействие в социальных сетях могут не только улучшить видимость вашего контента, но и способствовать получению естественных ссылок через широкое распространение вашего контента пользователями.

Гостевое блогирование

Публикация статей на других релевантных и авторитетных сайтах может быть отличным способом получения качественных ссылок, но важно избегать чрезмерного и спама, что может привести к пенальти.

Контент-фильтры: как создать идеальный контент для Google

Контент-фильтры Google служат для того, чтобы обеспечивать пользователям высококачественные и релевантные результаты поиска, отсеивая низкокачественный контент. Эти фильтры оценивают контент сайтов по различным параметрам и могут существенно повлиять на ранжирование сайта в поисковой выдаче.

Понимание этих фильтров и создание соответствующего контента — ключ к успешному SEO. Рассмотрим, какие существуют контент-фильтры и как создавать идеальный контент, который будет отвечать требованиям Google.

Виды контент-фильтров:

Фильтр «Панда»

Один из наиболее известных контент-фильтров Google, направлен на борьбу с низкокачественным контентом. Он нацелен на сайты с избыточным количеством рекламы, плохо организованным или дублированным контентом, а также на сайты, которые предоставляют мало или никакой уникальной добавочной стоимости пользователям.

Фильтр за переоптимизацию

Реагирует на избыточное использование SEO-приемов: ключевых слов (keyword stuffing) и ненатурального использования фраз в тексте, что делает контент неестественным и затрудняет его чтение.

Фильтр за скрытый контент и перенаправления

Отслеживает скрытый текст и невидимые перенаправления, которые предназначены для манипулирования поисковыми роботами, а не для удовлетворения потребностей пользователей.

Советы по созданию качественного контента:

Ориентация на пользователя

Контент должен быть создан с учетом интересов и потребностей целевой аудитории. Это означает, что информация должна быть полезной, информативной и интересной. Уделяйте внимание темам, которые волнуют вашу аудиторию, и предоставляйте уникальные, ценные данные или анализ.

Уникальность и качество

Избегайте дублирования контента как внутри сайта, так и между сайтами. Google ценит уникальный контент, который приносит новую информацию или уникальную точку зрения в рассматриваемую тему. Проверяйте тексты на плагиат, и активно используйте инструменты для проверки уникальности.

Естественное использование ключевых слов

Избегайте искусственной вставки большого количества ключевых слов. Ключевые слова должны вписываться в текст естественно, не нарушая его читаемости. Планирование контента с помощью семантического кластеризации организует материалы так, чтобы они были одновременно SEO-эффективными и полезными для читателя.

Сложные фильтры и их управление: «Панда», «Пингвин» и другие

«Панда» и «Пингвин» играют ключевую роль в определении ранжирования сайтов в Google. Они улучшают качество поисковой выдачи, наказывая сайты, которые используют манипулятивные методы SEO или предоставляют низкокачественный контент.

Понимание работы этих фильтров и разработка стратегий для их эффективного управления может значительно улучшить SEO-производительность сайта.

Фильтр «Панда»

Фильтр «Панда» был впервые введен в 2011 году и нацелен на сайты с низкокачественным контентом. Он анализирует содержание сайта на предмет дублирования, избытка рекламы, наличия поверхностного или нерелевантного контента, а также страниц, которые не приносят значительной пользы пользователям.

Сайты, нарушающие эти критерии, могут столкнуться с понижением в ранжировании по широкому спектру запросов. Для управления фильтром «Панда» важно создавать уникальный, глубоко проработанный контент, который решает конкретные запросы пользователей, а также проводить регулярный аудит контента, удаляя или перерабатывая неудачные страницы.

Фильтр «Пингвин»

Фильтр «Пингвин», запущенный в 2012 году, фокусируется на наказании сайтов за манипулятивные практики построения ссылок. Основное внимание уделяется искусственным, манипулируемым или неестественным ссылкам, которые предназначены для повышения ранга сайта в поисковой выдаче.

Чтобы избежать негативного влияния «Пингвина», необходимо отказаться от покупки ссылок и использования сетей обмена ссылками, а вместо этого сосредоточиться на получении качественных, естественных ссылок. Проведение регулярного аудита обратных ссылок и использование Google Search Console поможет идентифицировать и отклонять подозрительные ссылки.

В отличие от алгоритма Google Penguin, который наказывает конкретные страницы сайта, ручные санкции от Google применяются ко всему веб-сайту в целом.

Другие сложные фильтры

Кроме «Панды» и «Пингвина», Google также использует другие алгоритмы:

- Hummingbird — помогает лучше понимать намерения пользователей за их запросами.

- Mobilegeddon — наказывает сайты, не адаптированные для мобильных устройств.

- Phantom — косвенно влияет на качество контента, и Fred, нацеленный на сайты с чрезмерным количеством рекламы, которые предоставляют мало полезного контента.

Стратегии работы с фильтрами

Для успешной работы с этими фильтрами важно сосредоточиться на создании качественного контента и строить естественную ссылочную массу. Регулярные аудиты сайта помогают выявлять и устранять SEO-проблемы, которые могут привести к применению санкций. Инвестиции в улучшение пользовательского опыта и техническую оптимизацию сайта также способствуют улучшению общего SEO-показателя и помогают избежать негативного влияния фильтров.

Специфические санкции Google: необычные случаи и их решения

Специфические санкции Google часто касаются уникальных или нестандартных проблем, которые могут возникнуть на сайтах. Эти санкции могут варьироваться от штрафов за специфические SEO-тактики до реакций на аномалии в поведении пользователей или технические проблемы на сайте. Вот несколько примеров таких санкций и советы по их предотвращению и устранению:

Санкции за избыточную рекламу

Google может наложить санкции на сайты, которые перегружены рекламными блоками, особенно если они мешают пользовательскому опыту. Это было частью обновления алгоритма, известного как Layout Algorithm Update.

Чтобы избежать такой санкции, важно сбалансировать рекламное содержимое и информационный контент на странице, убедившись, что реклама не мешает доступу к основному контенту и не ухудшает общий пользовательский опыт.

Санкции за скрытый текст или ссылки

Некоторые сайты могут пытаться манипулировать ранжированием, используя текст или ссылки, которые видны поисковым роботам, но не пользователям. Это включает в себя использование текста цвета фона или расположение текста за пределами видимой области экрана.

Чтобы избежать таких санкций, следует избегать любых практик, которые могут восприниматься как попытка обмануть поисковые системы. Все элементы на странице должны быть четко видны пользователям и предназначены для улучшения их опыта.

Наказания за быстрые и агрессивные SEO-кампании

Иногда сайты могут получить временное понижение в ранжировании, если Google обнаружит необычно быстрое накопление обратных ссылок или другие агрессивные SEO-методики, что может сигнализировать о попытках манипулирования рейтингом.

Для предотвращения этого важно развивать SEO-стратегии постепенно и органично, фокусируясь на создании качественного контента и получении натуральных ссылок.

Санкции за манипуляции с микроразметкой

Google может наложить санкции на сайты, которые неправильно используют структурированные данные, например, вводя в заблуждение или некорректные данные в сниппеты.

Чтобы избежать этого, убедитесь, что ваша микроразметка точно отражает содержимое страницы и соответствует рекомендациям Google по использованию структурированных данных.

В каждом из этих случаев ключ к устранению и предотвращению санкций заключается в строгом соответствии с рекомендациями Google и лучшими практиками SEO. Регулярный мониторинг и аудит сайта помогут выявлять потенциальные проблемы до того, как они приведут к санкциям, обеспечивая стабильное и устойчивое ранжирование в поисковой выдаче.

Будущее SEO и адаптация к изменениям в алгоритмах

Будущее SEO будет продолжать развиваться в ответ на изменения в алгоритмах поисковых систем, особенно Google. Прогнозируется, что алгоритмы станут ещё более умными и сосредоточенными на понимании намерений пользователей, качестве контента и пользовательском опыте.

Это потребует от SEO-специалистов и вебмастеров адаптации своих стратегий, чтобы оставаться в числе лидеров поисковой выдачи. Рассмотрим ключевые тенденции и стратегии адаптации, которые могут помочь справиться с этими изменениями.

Прогнозы изменений в алгоритмах:

Улучшенное понимание контекста и семантики

Google продолжит развивать свои возможности понимания естественного языка с помощью алгоритмов, основанных на искусственном интеллекте и машинном обучении, таких как BERT и последующие итерации. Это означает, что контекст и намерения за поисковыми запросами будут играть ещё большую роль, и сайты должны будут предоставлять более таргетированный и релевантный контент.

Ещё больший акцент на пользовательском опыте (UX)

Скорость загрузки страниц, удобство навигации, мобильная адаптивность и общее взаимодействие пользователя с сайтом будут иметь ещё большее значение. Google уже начал использовать такие показатели, как Core Web Vitals, чтобы оценивать UX и интегрировать их в факторы ранжирования.

Безопасность и конфиденциальность

В условиях растущей озабоченности по поводу конфиденциальности данных ожидается, что Google уделяет больше внимания безопасности сайтов. Протоколы HTTPS и безопасное обращение с пользовательскими данными станут ещё более важными.

Стратегии адаптации:

Фокус на качественном контенте

Создавайте глубокий, информативный и хорошо исследованный контент, который удовлетворяет информационные потребности вашей аудитории. Важно использовать комплексный подход к семантике и структуре контента, который помогает Google лучше понимать и классифицировать ваш контент.

Инвестиции в техническое SEO

Уделяйте внимание техническим аспектам вашего сайта, включая скорость загрузки, мобильную адаптивность и структуру данных. Регулярные технические аудиты и оптимизация помогут улучшить общую

производительность сайта и его восприятие поисковыми системами.

Персонализация и нацеливание на конкретные аудитории

Постарайтесь понять своих пользователей и создавать контент, который отвечает их уникальным потребностям. Это может включать в себя локализацию контента, персонализацию пользовательского опыта и предоставление контента, который поддерживает различные этапы пользовательского пути.

В свете этих изменений важно продолжать обучение и быть в курсе последних трендов и обновлений алгоритмов. Постоянное образование и адаптация к новым требованиям помогут сохранить и улучшить видимость ваших сайтов в поисковых системах.

Теги публикации: продвижение сайта, раскрутка сайта, санкции google, фильтр панда, фильтр пингвин, фильтры google

![[Идеальный аудит сайта] Шаг №21: как быстро проверить теги TITLE, Description и HTML на спам, дубли и длину, чтобы получить максимум трафика из поисковых систем | Кейс от агентства optimism.ru [Идеальный аудит сайта] Шаг №21: как быстро проверить теги TITLE, Description и HTML на спам, дубли и длину, чтобы получить максимум трафика из поисковых систем | description, html, title, заголовки на сайте, ключевые слова](https://optimism.ru/blog/wp-content/uploads/2023/10/metatags_title_description-e1697488650100-300x170.jpg)

![[Идеальный аудит сайта] Шаг №20: анализ ссылочного профиля, естественных и органических ссылок, разработка ссылочной стратегии для продвижения сайта | Кейс от агентства optimism.ru [Идеальный аудит сайта] Шаг №20: анализ ссылочного профиля, естественных и органических ссылок, разработка ссылочной стратегии для продвижения сайта | PR, seo, seo-аналитика, анализ проекта, Естественные ссылки](https://optimism.ru/blog/wp-content/uploads/2023/08/estestvennye-ssylki.gif)

![[Идеальный аудит сайта] Шаг №19: Анкоры и семантика, покупные ссылки, BM25, анализ и проверка анкор-листа на спам и наличие уникальных биграмм | Кейс от агентства optimism.ru [Идеальный аудит сайта] Шаг №19: Анкоры и семантика, покупные ссылки, BM25, анализ и проверка анкор-листа на спам и наличие уникальных биграмм | seo, seo-аналитика, анализ проекта, анкоры, идеальный аудит](https://optimism.ru/blog/wp-content/uploads/2023/09/ankors-e1694808723500-300x170.jpg)

Такой подход позволяет увеличить спрос и снизить стоимость каждого клиента

Оптимизация сайта под максимально широкий пул ключевых запросов

Вид поискового продвижения, при котором оплата производится за целевые действия